尤度比検定の最強力性はほぼ自明

#数楽 「尤度比検定が最強力検定である」というNeyman-Pearsonの定理はものすごく自明な結果。以下に述べる自明な結果はベイズ検定も含んでいる。確率変数Xは確率分布p(x)dx、q(x)dxのどちらかに従っていると仮定する。どちらに従っているかを知りたい。続く

#数楽 続き。確率分布 p, qのそれぞれにおける条件f(X)>aの確率をP_p(f(X)>a)=∫_{f(x)>a}p(x)dx、P_q(f(X)>a)=∫_{f(x)>a}q(x)dxと書く。続く

#数楽 続き。函数f(X)に従う検定とは「Xの値がf(X)>aを満たしているとき、確率分布はpではなくqであると判定することである」。確率分布がpなのにf(X)>aとなる確率は小さな方が良いが、確率分布がqならばf(X)>aとなる確率は大きな方が良い。続く

#数楽 続き。fとgについて「任意のa,bについて、確率分布がpのときのf(X)>aとなる確率とg(X)>bとなる確率が等しいならば、確率分布がqのときのf(X)>aとなる確率はg(X)>bとなる確率以上になる」が成立しているとき、fによる検定はgによる検定より強力であると言う。

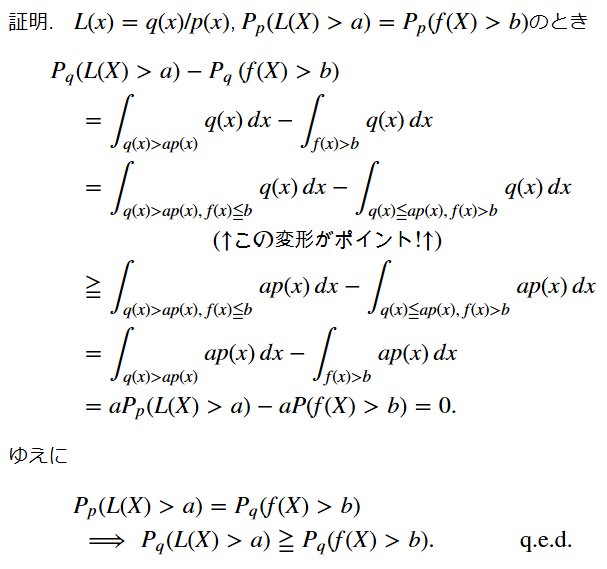

#数楽 続き。定理:L(X)=q(X)/p(X)による検定は最強力である。証明は極めて容易なので、ある程度数学に慣れた人なら、以下の説明を見ない方が証明を書き下し易いだろう。証明:P_p(q(X)/p(X)>a)=P_p(f(X)>b)と仮定する。続く

#数楽 続き。P_q(q(X)/p(X)>a)-P_q(f(X)>b)≧0を示せばよい。(左辺)=∫_{q(x)>ap(x)}q(x)dx-⌠_{f(x)>b}q(x)dxの共通の積分領域を除くと(ここだけがちょっとしたアイデアを使っている)~続く

#数楽 続き=∫_{q(x)>ap(x),f(x)≦b}q(x)dx-⌠_{q(x)≦ap(x),f(x)>b}q(x)dx≧∫_{q(x)>ap(x),f(x)≦b}ap(x)dx-⌠_{q(x)≦ap(x),f(x)>b}ap(x)dx続く

#数楽 続き= ∫_{q(x)>ap(x)}ap(x)dx-⌠_{f(x)>b}ap(x)dx=aP_p(q(x)/p(x)>a)-aP(f(X)>b)=0 (最初の仮定より).これで示すべきことが示された。 q.e.d.続く

#数楽 続き。サンプルの値Xに対するL(X)=q(X)/p(X)を尤度比と呼ぶ。尤度比検定は最強力である。この超絶シンプルな場合に関する結果はNeyman-Pearsonの定理やベイズ検定に関する結果を含んでいる。しかし、多くの教科書ではごちゃごちゃ難しく書いてある。続く

#数楽 続き。Neyman-Pearsonの定理のケースではサンプルが一つのXではなく独立同分布なX_1,…,X_nに変わるが、それらをまとめてX=(X_1,…,X_n)と書けば以上で述べた結果の特別な場合になる。続く

#数楽 続き。ベイズ検定の場合にもサンプルはX=(X_1,…,X_n)の形になり、XはZ(x_1,…,x_n|φ)=∫p(x_1|w)…p(x_n|w)φ(w)dwという分配函数の形の確率分布(密度函数)に従うと考えれば、以上で述べた結果の特別な場合になります。続く

#数楽 続き。事前分布φ,ψに関するベイズ検定において、L(X)=Z(X_1,…,X_n|ψ)/Z(X_1,…,X_n|φ)関する検定が最強になります。(この結果は上の方ですでに述べたシンプルな場合を知っていれば自明。分母をp(X)と書き、分子をq(X)と書けばよい。)

#数楽 補足。パラメーターw付きのxに関する確率分布(密度函数)p(x|w)とパラメーターwに関する確率分布φ(w)に対して、分配函数Z(x_1,…,x_n|φ)=∫p(x_1|w)…p(x_n|w)φ(w)dwはx_1,…,x_nに関する確率密度函数になります。続く

#数楽 続き。確率密度函数Z(x_1,…,x_n|φ)=∫p(x_1|w)…p(x_n|w)φ(w)dwで定義された確率分布は次のような様子を想像すると理解し易いです。パラメーターw付きのxに関する確率密度函数p(x|w)はパラメーターの分だけ複数のルーレットがある状況だと~続く

#数楽 続き~解釈できます。パラメーターwで指定されたルーレットを回したときにa≦x≦bの値xが出る確率は∫_a^b p(x|w)dxになる。パラメーターwの確率密度函数φ(w)はどのルーレットを回すかを決めるルーレットだと解釈できます。続く

#数楽 続き。そのときp(x_1|w)…p(x_n|w)はルーレットwをn回まわしたときx_1,…,x_nが出る確率の密度を意味します。だからZ(x_1,…,x_n|φ)=∫p(x_1|w)…p(x_n|w)φ(w)dwは、ルーレットφを回して出た値wで指定された~続く

#数楽 続き~ルーレットをn回まわして出た値がx_1,…,x_nになる確率の密度を意味していることになります。wで積分しているのでどのルーレットをまわすかを決めるためのルーレットφは外から見えなくなっています。表に出て来るのはどれか一つのルーレットをn回まわして出た値だけ。

#数楽 続き。モデル(パラメーター付きの確率分布p(x|w)と事前分布φ(w))を指定して、現実の未知の確率分布q(x)が生成したサンプルX_1,…,X_nから、モデル世界における条件付き確率分布Z(X_1,…,X_n,x)/Z(X_1,…,X_n)を考えると~続く

#数楽 続き~モデルの設定がどうであってもそのモデルで実現できる範囲内で予測分布p(x)=Z(X_1,…,X_n,x)/Z(X_1,…,X_n)はn→∞でサンプルX_1,…,X_nを生成した未知の確率分布q(x)に(Kullback-Leibler情報量の意味で)近付きます。続く

#数楽 続き。条件付き確率に関するなにがしかの直観を持っていれば、サンプルX_1,…,X_nによって制限された条件付き確率分布p(x)=Z(X_1,…,X_n,x)/Z(X_1,…,X_n)を考えれば、サンプルを生成された確率分布に近付きそうな感じがすると思います。続く

#数楽 続き。しかし、その部分は数学的に非自明であり、ベイズの定理の類の自明な定理からは出て来ません。ベイズ統計を勉強するときに、ベイズの定理からベイズ統計の原理が出て来るように解説してあるものが多いのですが、そのような説明の仕方は誤解を招く非常によろしくないものです。続く

#数楽 ベイズ統計の原理を誤解しないためには「ベイズ推定は最尤法と同じようなものだ」と考えるとよいです。「ベイズ統計では事前確率という主観確率を考えるので客観的な最尤法とは全然違う」と考えた瞬間にひどい誤解をしてしまったことになります。誤解させる解説が多数派なのが大問題。続く

#数楽 続き。最尤法について書かれた教科書では、n→∞で尤度函数p(X_1|w)…p(X_n|w)の台がある特定のパラメーターの値w=θの周囲に集中して来るような設定になっているはずです(モデルが正則な設定)。その設定ならベイズ推測の正当化をすることは容易です。続く

#数楽 続き。複雑なモデルでも通用するようなより一般的な設定でのベイズ統計の原理の数学的正当化については、渡辺澄夫著『ベイズ統計の理論と方法』 https://www.amazon.co.jp/dp/4339024627 という教科書があります。物理の統計力学に関する素養があれば読み易いと思います。

#数楽 続き。ベイズ推測なら有効な一般的な設定では、最尤法は有効な方法ではなくなる場合があるという話もその本に書いてあります。モデルが単純なら最尤法で何の問題もないのですが、モデルが複雑になると最尤法は使用できない場合があるということのようです。続く

#数楽 https://twitter.com/genkuroki/status/838996495969898496 …日本語訂正誤「サンプルを生成された確率分布に近付きそうな感じがする」正「サンプルを生成した確率分布に近付きそうな感じがする」他にもたくさんの誤りがあると思います。ごめんなさい。

#数楽 例:p(x|w)=exp(-(x-μ)^2/(2σ^2))/√(2πσ^2) (正規分布、w=(μ,σ))の場合には、最尤法やベイズ推測による予測分布はサンプルを生成している未知の分布と同じ平均と分散を持つ正規分布に近付くことになります。

#数楽 最初の話に戻る。「サンプルXを生成する確率分布がp(x)とq(x)のどちらかである」と仮定したことは忘れてはいけないこと。現実の観測で得られたサンプルXはp(x)とq(x)以外の確率分布で生成されているかもしれない。続くhttps://twitter.com/genkuroki/status/838954965640978432 …

#数楽 続き。「サンプルXを生成する確率分布はp(x)とq(x)のどちらかである」という仮定のもとで最強力検定である尤度比検定を使うことは合理的ですが、その合理性はp(x)とq(x)のどちらかが真の分布であることを含んでいません。だから、現実には全然合理的でない可能性がある。

#数楽 続き。「そもそもそのモデルってどんだけ"正しい"の?」という疑問が決定的に重要なケースでは「そのモデルの正しさを信じている人にとっての合理性」は現実には全然合理的ではない可能性が高い。Waldの定理の社会科学での利用はこのような点に十分な注意を払うべきだと思います。

#数楽 Waldの定理の超絶特別な場合に関する補足。以上で扱ったシンプルな尤度比検定を「主観的な確信に基いた損失の期待値を最小する判断」として出す話。A氏の主観的確信に関する設定:・Xの確率分布はp(x)とq(x)のどちらかだとA氏は信じている。続く

#数楽 続き・Xの確率分布がp(x)である確率はθで、q(x)である確率は1-θだと思っている。(0<θ<1と仮定する。)・Xの確率分布がp(x)なのにq(x)だと判断すると損失k>0が発生し、真の確率分布がq(x)なのにp(x)だと判断すると損失l>0が発生する。続く

#数楽 続き・A氏はXの実現値が集合Qに含まれていたらXの確率分布はq(x)だと判断し、そうでなければp(x)だと判断する。・A氏は自分の主観に基いて計算した損失の期待値R(Q)が最小になるようにXの値の集合Qを定める。問題:そのようなXの値の集合Qを求めよ。続く

#数楽 証明:A氏の主観的期待損失はR(Q)=kθ⌠_Q p(x)dx + l(1-θ)⌠_{Q^c} q(x)dx=kθ⌠_Q p(x)dx + l(1-θ)(1-⌠_Q q(x)dx)=∫_Q(kθp(x)-l(1-θ)q(x))dx+l(1-θ)と書ける。続く

#数楽 続き。これを最小にするためにはkθp(x)-l(1-θ)q(x)が負になる領域上の積分にすればよい。すなわちQ={ x | kθp(x)-l(1-θ)q(x)<0 }={ x | q(x)/p(x)>kθ/(l(1-θ)) }とすればよい。q.e.d.

#数楽 まとめ:Xの分布がp(x)である主観的確率がθで、kが実際にはp(x)なのにq(x)だと誤認したときの損失で、lはq(x)なのにp(x)だと誤認したときの損失であるとき、q(x)/p(x)>kθ/(l(1-θ))ならXの分布はq(x)だと判定することが主観的な最適解。

#数楽 続き。たとえば、実際にはXの分布はp(x)なのにq(x)だと判定してしまったときの損失kが大きければ、kθ/(k(1-θ))も大きくなり、Xの分布がq(x)だと判定するための基準が厳しくなる。θとlが変化した場合も同様に納得できる結論が得られる(当然!)。続く

#数楽 続き。以上のシンプルな結果は、当たり前の話だが、XがX=(X_1,…,X_n)のようになっていても同様に成立している。ただし、以上で述べた型の合理性は現実の確率分布が検定の結果識別された確率分布になっていることを何も保証しない。A氏個人の主観的な合理性に過ぎない。

#数楽 記号:・X_i は「Xの右下に小さくi」・a^b は「aの右上に小さくb」・⌠_Q は「集合Q上での積分」・たとえば区間[a,b]上での積分は∫_{[a,b]}=∫_a^b・確率密度函数p(x)に関する集合Qの確率は∫_Q p(x)dxになる。などなど

#数楽 注意:A氏の主観の設定の中にXの分布がp(x)である主観確率θが含まれているので、ベイズ統計的な設定になっているように感じる人がいるかもしれない。しかし、その手の主観確率とベイズ統計の設定における事前確率は違うものだと思った方がよいと思う。